Реферат: Помехоустойчивое кодирование, распознавание символов

Реферат: Помехоустойчивое кодирование, распознавание символов

Zi Zj

|

|

|

Рисунок 1.1.1 - Структура передачи информации

Источник генерирует последовательность сообщений из ансамбля {V, P(V)},

где V – символ сообщения;

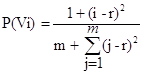

P(V) – вероятность символа сообщения, рассчитываемая по формуле:

![]()

(1.1.1)

(1.1.1)

где i=1…m;

m, r – заданные величины.

Кодер источника кодирует сообщение Vi в Zi по алгоритму Шеннона-Фэно.

Энтропия сообщения H(Z), бит/символ вычисляется по следующей формуле:

![]() (1.1.2)

(1.1.2)

Формула для расчета средней длины кода Lср, бит имеет вид:

![]() (1.1.3)

(1.1.3)

где L(Zi) – длина кода, бит;

P(Zi) – вероятность кода.

Максимальная энтропия H(Z)max, бит/символ неравномерного двоичного кода Zi определяется по формуле:

![]() (1.1.4)

(1.1.4)

Зная среднюю длину кода, можно определить коэффициент эффективности Кэф кода Zi по формуле:

![]() (1.1.5)

(1.1.5)

Для расчета коэффициента избыточности Кизб используется формула:

![]() (1.1.6)

(1.1.6)

Кодер канала осуществляет простое кодирование повторением n = 3 раз каждого двоичного сигнала сообщения Zi. Таким образом, имеется всего два кода:

Х1=(0 0 0) Х2=(1 1 1)

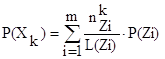

Вероятность каждого из них определяется по формуле:

(1.1.7)

(1.1.7)

где к=0,1;

![]() -

количество элементов «к» в коде Zi.

-

количество элементов «к» в коде Zi.

При передаче Xк по каналу связи возможны ошибки с вероятностями, определяемыми следующим образом:

P10=0.2 + 0.02A (1.1.8)

P01=0.2 + 0.02B (1.1.9)

где р10 – вероятность принятия нуля при передаче единицы;

р01 – вероятность принятия единицы при передаче нуля;

А, В – заданные величины.

В дальнейшем, для удобства будут использоваться следующие принятые обозначения:

Х - передаваемый код;

Y - принимаемый код.

При построении канальной матрицы P(Y/X) воспользуемся тем, что при передаче может произойти ошибка лишь в одном разряде X1 или X2.

Тогда в 1 строке матрицы элементы определятся следующим образом:

![]() 1 – p01 , i = 1

1 – p01 , i = 1

P(xi,yj) = P01/3 , i = 2,3,4. (1.1.10)

0 , i = 5,6,7,8.

Элементы канальной матрицы совместной вероятности P(X,Y) определяются по формуле:

P(xi,yj)=P(xi)P(yj/xi) (1.1.11)

Зная матрицу совместной вероятности P(X,Y), можно вычислить элементы матрицы вероятностей P(Y). Они находятся по формуле:

P(yi)=P(x1,yi)+ P(x2,yi) (1.1.12)

В свою очередь, формула для расчета элементов матрицы условной вероятности P(X/Y) имеет вид:

P(xi/yj)=P(xi,yj)/P(yj) (1.1.13)

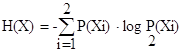

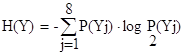

Энтропия передаваемого сигнала H(X), бит/символ и принимаемого сигнала H(Y), бит/символ определяется соответственно по формуле:

(1.1.14)

(1.1.14)

(1.1.15)

(1.1.15)

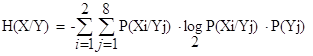

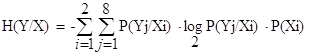

Условные энтропии H(X/Y), бит/символ и H(Y/X), бит/символ рассчитываются соответственно по формулам:

(1.1.16)

(1.1.16)

(1.1.17)

(1.1.17)

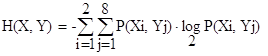

Совместная энтропия H(X,Y), бит/символ находится по формуле:

(1.1.18)

(1.1.18)

Взаимная энтропия I(X,Y), бит/символ определяется по формуле:

![]() (1.1.19)

(1.1.19)

Передача информации по каналу связи осуществляется со скоростью V, рассчитываемой по формуле:

V = 1000(A+1) (1.1.20)

Постоянную скорость передачи двоичных символов по каналу связи R, бит/с можно рассчитать по формуле:

R = V × I(X,Y) / 3; (1.1.21)

Производительность источника ![]() , бит/с определяется по

следующей формуле:

, бит/с определяется по

следующей формуле:

![]() = (H(X) × V ) (1.1.22)

= (H(X) × V ) (1.1.22)

1.2 ПОЛУЧЕННЫЕ РЕЗУЛЬТАТЫ

По условию варианта определены следующие постоянные:

m = 15;

r = 10;

Определим характеристики посылаемых символов.

Вероятности символов Vi(они же - вероятности кода Zi), генерируемых источником рассчитываем по формуле 1.1.1. Полученные значения вероятностей приведены в таблице 1.2.2.

Сначала вероятности строятся по убыванию. После этого все вероятности делятся на две группы так, чтобы в пределах каждой группы их значения были примерно одинаковыми. В старший разряд кодов, соответствующих первой группе вероятностей, записывается 1,для второй группы кодов – 0. Затем каждая из полученных подгрупп, в свою очередь, делится аналогичным образом. При прохождении цикла деления по одному разряду происходит переход на разряд вправо. Деление продолжается до тех пор, пока в каждой группе не окажется по одному коду.

Результаты разработки кодов показаны в таблице 1.2.1.

Таблица 1.2.1 - Вероятности и коды символов

| Vi | P(Vi) | Zi | L(Zi) |

| 1 | 0.231 | 11 | 2 |

| 2 | 0.183 | 10 | 2 |

| 3 | 0.1408 | 011 | 3 |

| 4 | 0.1042 | 0101 | 4 |

| 5 | 0.0732 | 01001 | 5 |

| 6 | 0.0732 | 01000 | 5 |

| 7 | 0.0479 | 00111 | 5 |

| 8 | 0.0479 | 00110 | 5 |

| 9 | 0.0282 | 00101 | 5 |

| 10 | 0.0282 | 00100 | 5 |

| 11 | 0.0141 | 00011 | 5 |

| 12 | 0.0141 | 00010 | 5 |

| 13 | 0.0056 | 000011 | 6 |

| 14 | 0.0056 | 000010 | 6 |

| 15 | 0.0028 | 000000 | 6 |

Вычислим энтропию сообщения H(Z),бит/символ по формуле